昨天介紹了Guiding Chatbot,讓Chatbot理解情緒並且嘗試引道話語者的情緒。

從昨天的研究我們可以知道,對於Chatbot而言,我們講出來的話(下稱話語,Utterance)其實包含了很多資訊。

如果是普通的Chit-chat,只需了解話語中涵蓋的情緒等簡單的語義,回覆與話語相符合的話即可。

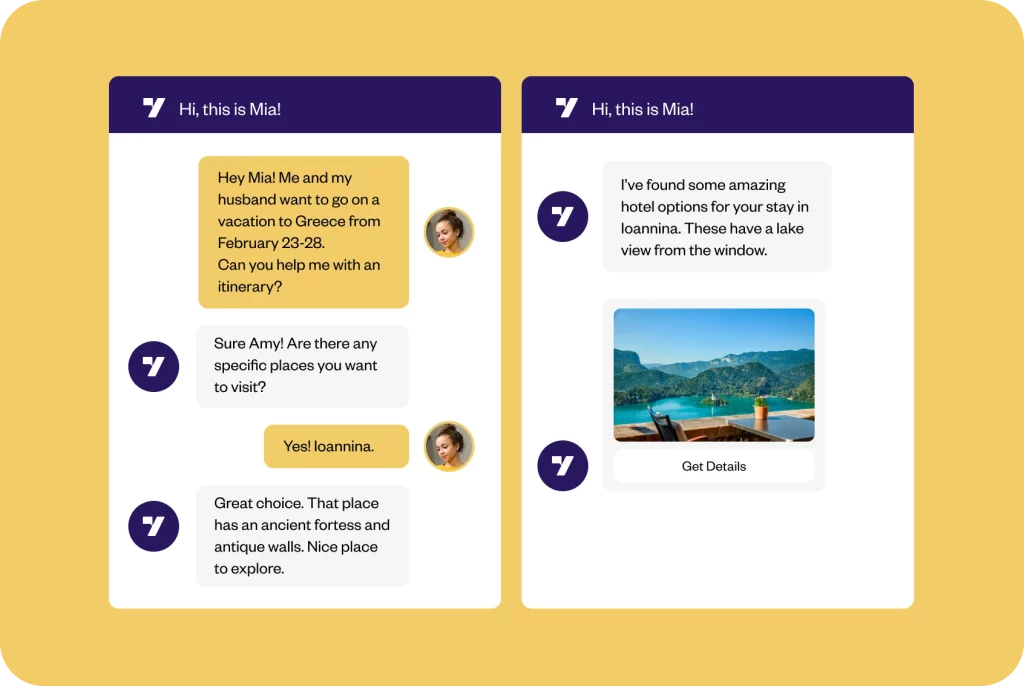

那假設今天我們不想Chatbot純聊天了,我們跟Chatbot說

「幫我訂10/15台灣到東京的來回機票」或「我想找一間有空房的酒店」

希望Chatbot能幫我們查詢航班或找住宿,那這時Chatbot該如何理解我們講的這句話呢?

我們希望Chatbot不僅能聊天,還能幫我們處理訂票等瑣碎雜事

這時我們還需讓Chatbot理解話語(Utterance)中的意圖(Intention)

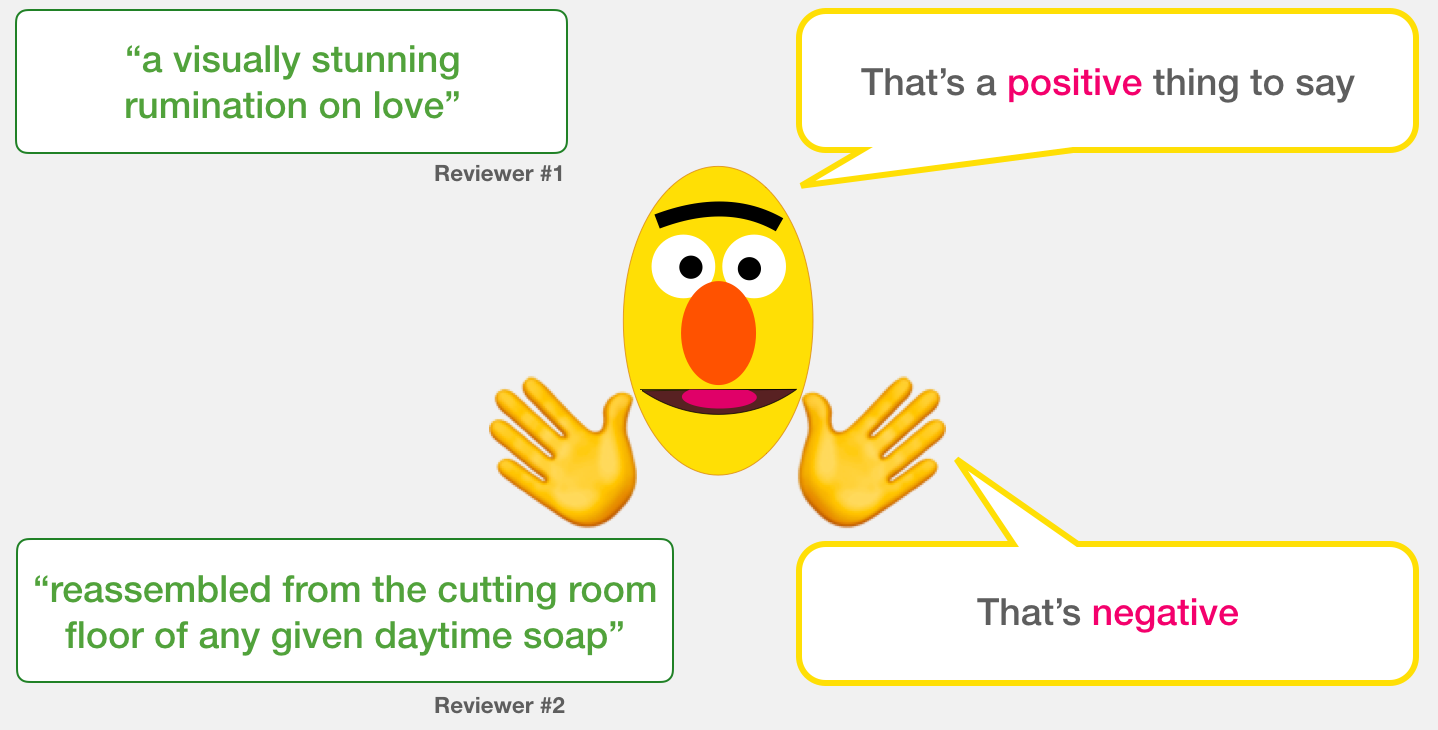

如下圖,所謂的意圖,就是話中所代表的目的或想做的事

比如說話語"Find a novel called industry"就包含了"Search_Creative_Work"的意圖

在自然語言處理(NLP)中,理解話語中的情緒、意圖或其他資訊的任務,

我們稱為自然語言理解(Natural Language Understanding)。

為了方便解說,我們以最廣為人知的BERT舉例LLMs如何做到NLU:

好加在我們生活於LLMs蓬勃發展的時代,

像BERT等LLMs已用大量語料進行預訓練(Pre-train),已對語意有初步的理解。

如果要讓語言模型知道使用者想做什麼,我們可以使用微調(Fine-tune)等技法。

像我們可以用聯合學習(Joint Learning)同時讓BERT學習分類和槽填充(Slot-filling)

JointBERT透過對BERT做聯合學習(微調的一種),讓BERT知道這段話的意圖是啥

那什麼是Slot-filling... 將會在之後的對話狀態追蹤(DST)介紹...

明天,將會以實作為各位介紹如何應用BERT、T5等語言模型於NLU任務,

來帶領各位理解LM如何分析話中所帶的意圖。

Reference.

IEEE-A Joint Learning Framework With BERT for Spoken Language Understanding

TOD-BERT: Pre-trained Natural Language Understanding for Task-Oriented Dialogue

Text Classification Using Embeddings

A Visual Guide to Using BERT for the First Time

The Illustrated BERT, ELMo, and co. (How NLP Cracked Transfer Learning)